DeepSeek的中國專利相關資訊與解析(此號專利目前正在審查中)(與GPT4o, Felo Search, DeepSeek R1的對話生成)

第一部分: 此號專利權利請求項

這份專利權利要求涉及 人工智慧(AI)模型訓練數據集的構建方法,其核心在於數據的劃分、索引、抽樣、隨機打亂、切分及批量讀取。

detail/init2?ZcEuIBwNsQ

權利要求

原文

1.一种人工智能模型训练数据集的构建方法,其特征在于包括以下步骤:

1)将数据集划分为若干大小相同的数据序列;

2)以数据序列为单位建立索引;

3)根据需求比例在数据集中抽取样本数据;

4)将样本数据以数据序列为单位混合并随机打乱;

5)将打乱后的样本数据进行均匀切分得到若干个数据块,每个数据块包含若干个完整的数据序列;

6)在每一步模型训练的数据输入时,通过索引批量读取相应数据块作为该步骤的模型训练数据。

2.根据权利要求1所述的一种人工智能模型训练数据集的构建方法,其特征在于,如果采用自行获取的数据构建数据集,需要在步骤1)之前对获取数据进行数据清洁以及tokenize的步骤。

3.根据权利要求2所述的一种人工智能模型训练数据集的构建方法,其特征在于,所述数据清洁包括原始数据的智能抽取、按行去重、哈希去重、规则过滤等步骤。

4.根据权利要求1‑3所述的一种人工智能模型训练数据集的构建方法,其特征在于,所述tokenize的步骤包括:长文本分解为最小单位的token,然后将token转化为向量的数据结构。

5.根据权利要求1‑4任一所述的一种人工智能模型训练数据集的构建方法,其特征在于,所述数据序列为一维数组,包括N个连续token。

6.根据权利要求1‑5任一所述的一种人工智能模型训练数据集的构建方法,其特征在于,步骤2)中所述索引为一维数组[index 1,index2,index 3,…,index i],index i代表第i个数据序列的第一个token的下标,所述下标为第i个数据序列中第一个token存储位置的偏移量。

7.根据权利要求1‑6所述的一种人工智能模型训练数据集的构建方法,其特征在于步骤3)‑步骤6)中的样本抽取、随机打乱、样本数据切分等数据操作均以数据序列为单位,通过索引进行操作,不实际修改存储单元中的数据。

8.根据权利要求1‑7所述的一种人工智能模型训练数据集的构建方法,其特征在于,所述批量读取通过异步IO实现。

9.一种终端装置,其特征在于包括:至少一个处理器和存储器;存储器,用于存储程序指令;处理器,用于调用并执行存储器中存储的程序指令,以使所述终端装置执行权利要求1‑8所述的人工智能模型训练数据集的构建方法。

10.一种计算机可读存储介质,其特征在于,计算机可读存储介质中存储有指令,当其在计算机上运行时,使得所述计算机执行权利要求1‑8所述的人工智能模型训练数据集的构建方法。

英文翻譯

英文

CLAIM 1] 1. A construction method of artificial intelligent model training data set, wherein it comprises the following steps: 1) dividing the data set into a plurality of data sequences of the same size; 2) establishing index by taking data sequence as unit; 3) extracting sample data in the data set according to the required proportion; 4) mixing the sample data with the data sequence as the unit and randomly scrambling; 5) uniformly cutting the scrambled sample data to obtain multiple data blocks, wherein each data block comprises multiple complete data sequences; 6) when each step model training the data input, through index batch reading corresponding data block as the model training data of the step.

[CLAIM 2] 2. The method for constructing artificial intelligence model training data set according to Claim 1, wherein if the data set is constructed by the self-obtained data, the step of cleaning the data and tokenize the obtained data is needed before the step 1).

[CLAIM 3] 3. The method for constructing artificial intelligence model training data set according to Claim 2, wherein said data cleaning comprises the steps of intelligently extracting the original data, removing the weight according to the row, removing the weight by Hash, and regularly filtering.

[CLAIM 4] 4. The construction method of artificial intelligence model training data set according to Claim 1 to 3, wherein the step of tokenize comprises: The long text is decomposed into the token of the minimum unit, and then the token is converted into the data structure of the vector.

[CLAIM 5] 5. The method for constructing artificial intelligent model training data set according to any one of Claims 1 to 4, wherein the data sequence is a one-dimensional array comprising N continuous tokens.

[CLAIM 6] 6. The method for constructing artificial intelligent model training data set according to any one of Claims 1 to 5, wherein the index in the step 2) is one-dimensional array [index 1, index2, index 3, …, index i]. The index i represents the subscript of the first token of the ith data sequence, and the index is the offset of the storage position of the first token in the ith data sequence.

[CLAIM 7] 7. The method for constructing artificial intelligent model training data set according to any one of Claims 1 to 6, wherein the sample extraction in the step 3) to the step 6) is randomly disturbed. The data operations such as sample data segmentation and so on take the data sequence as the unit, and operate through the index, and do not actually modify the data in the storage unit.

[CLAIM 8] 8. The method for constructing artificial intelligence model training data set according to any one of Claims 1-7, wherein said batch reading is realized by asynchronous IO.

[CLAIM 9] 9. A terminal device, wherein it comprises: at least one processor and memory; a memory for storing program instructions; a processor for invoking and executing the program instructions stored in the memory so that the terminal device executes the method for constructing the artificial intelligent model training data set according to any one of Claims 1-8.

[CLAIM 10] 10. A computer readable storage medium, wherein the computer readable storage medium is stored with instructions; when the computer is operated on the computer, the computer executes the construction method of artificial intelligence model training data set according to any one of Claims 1-8.

Felo Search的結構

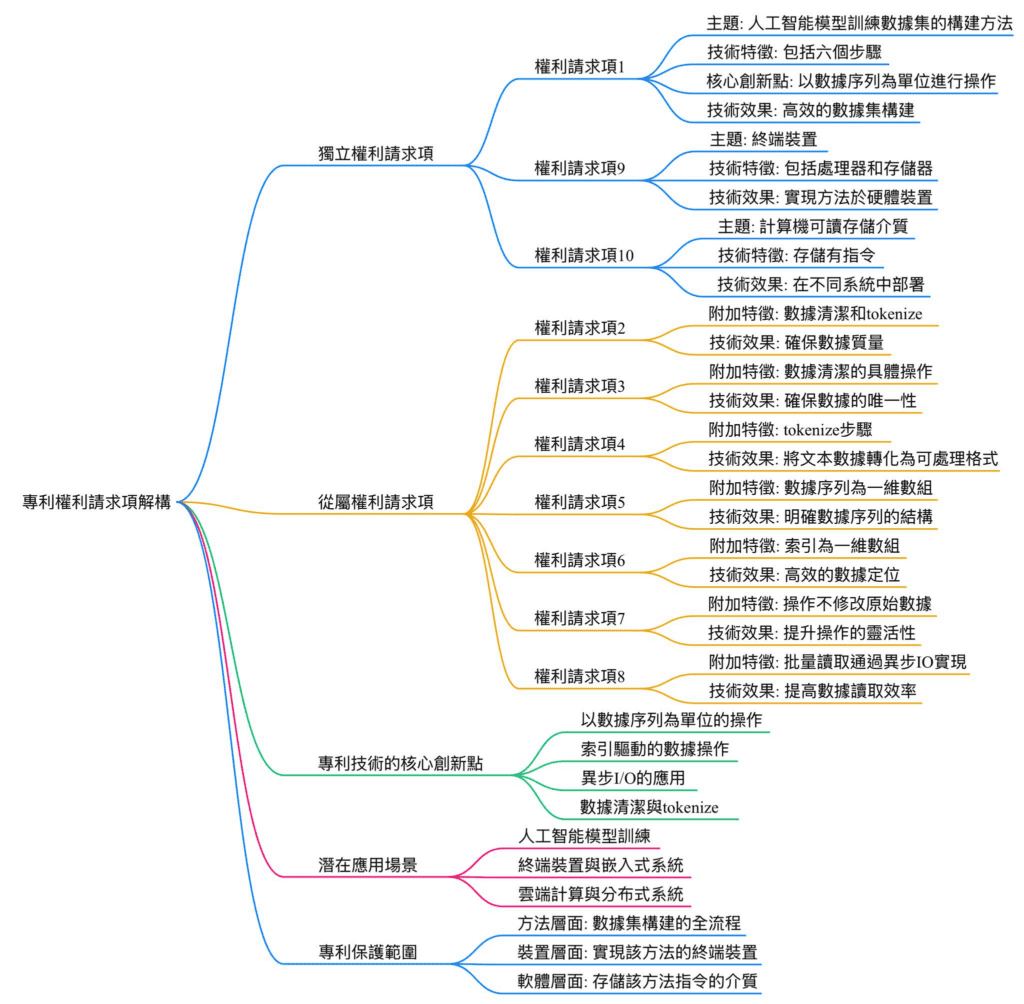

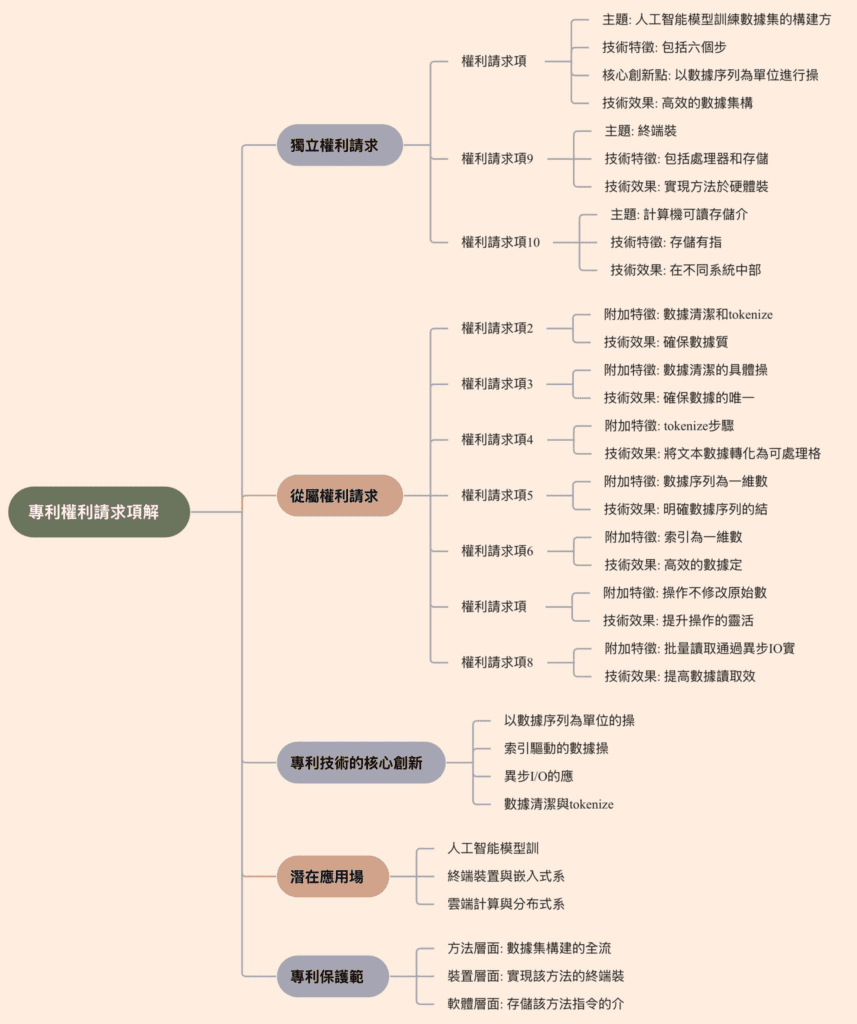

以下是針對您提供的專利權利請求事項的解構與分析,逐一拆解每項權利要求的技術特徵,並以繁體中文進行詳細說明:

權利要求解構

權利要求1

技術特徵:

數據集的劃分:將數據集劃分為若干大小相同的數據序列。

建立索引:以數據序列為單位建立索引。

樣本抽取:根據需求比例從數據集中抽取樣本數據。

數據混合與隨機打亂:將樣本數據以數據序列為單位混合並隨機打亂。

數據切分:將打亂後的樣本數據均勻切分為若干數據塊,每個數據塊包含若干完整的數據序列。

批量讀取:在模型訓練的每一步中,通過索引批量讀取相應數據塊作為訓練數據。

核心創新點:

以數據序列為單位進行操作,確保數據完整性。

使用索引進行批量讀取,提升數據處理效率。

權利要求2

技術特徵:

在自行獲取數據構建數據集的情況下,需在劃分數據集之前進行數據清潔和tokenize。

核心創新點:

增加了數據清潔和tokenize的前置處理步驟,確保數據質量。

權利要求3

技術特徵:

數據清潔包括以下步驟:

原始數據的智能抽取。

按行去重。

哈希去重。

規則過濾。

核心創新點:

提供了具體的數據清潔方法,涵蓋多種去重和過濾技術,提升數據準確性。

權利要求4

技術特徵:

tokenize步驟包括:

將長文本分解為最小單位的token。

將token轉化為向量形式的數據結構。

核心創新點:

將文本處理細化為token化和向量化,適配人工智能模型的輸入需求。

權利要求5

技術特徵:

數據序列定義為一維數組,包含N個連續的token。

核心創新點:

明確數據序列的結構為一維數組,便於後續操作。

權利要求6

技術特徵:

索引為一維數組形式,格式為[index 1, index 2, index 3, …, index i]。

每個索引值代表對應數據序列中第一個token的存儲位置偏移量。

核心創新點:

使用索引記錄數據序列的起始位置,實現高效定位。

權利要求7

技術特徵:

樣本抽取、隨機打亂、數據切分等操作均以數據序列為單位,通過索引進行操作,而不直接修改存儲單元中的數據。

核心創新點:

操作基於索引進行,避免直接修改數據,提升操作效率與數據安全性。

權利要求8

技術特徵:

批量讀取通過異步I/O實現。

核心創新點:

引入異步I/O技術,進一步提升數據讀取效率。

權利要求9

技術特徵:

一種終端裝置,包括:

至少一個處理器。

存儲器,用於存儲程序指令。

處理器執行程序指令以實現權利要求1-8所述的方法。

核心創新點:

將方法實現於硬體裝置中,擴展應用場景。

權利要求10

技術特徵:

一種計算機可讀存儲介質,存儲有指令,當在計算機上運行時,實現權利要求1-8所述的方法。

核心創新點:

將方法實現於軟體層面,便於部署於多種計算環境。

總結

該專利的技術特徵主要圍繞人工智能模型訓練數據集的構建方法,通過數據序列化、索引化、隨機打亂、異步I/O等技術,實現高效的數據處理與模型訓練。其創新點在於:

以數據序列為單位進行操作,確保數據完整性。

使用索引和異步I/O技術提升數據處理效率。

提供了詳細的數據清潔與tokenize步驟,確保數據質量。

該專利的技術方案適用於大規模人工智能模型的訓練場景,具有較高的實用價值。

GPT4o的解讀

這份專利權利要求涉及 人工智慧(AI)模型訓練數據集的構建方法,其核心在於數據的劃分、索引、抽樣、隨機打亂、切分及批量讀取。以下是對各個權利項的解構分析:

獨立權利項

1. 權利要求 1(方法核心)

• 方法步驟:

1. 數據劃分:將數據集劃分為等大小的數據序列。

2. 建立索引:以數據序列為單位建立索引。

3. 抽樣:根據需求比例抽取樣本數據。

4. 混合與隨機打亂:將抽取的樣本按數據序列混合並隨機打亂。

5. 數據切分:將打亂後的數據進一步劃分成若干個數據塊,每個數據塊包含若干完整的數據序列。

6. 批量讀取:在每次模型訓練時,通過索引批量讀取相應數據塊作為輸入數據。

• 技術要點:

• 基於數據序列的處理(而非單個數據點)。

• 使用索引進行操作,減少數據修改,優化效率。

• 數據打亂與切分 以增強數據多樣性,提高訓練效果。

2. 權利要求 9(終端裝置)

• 裝置結構:

• 處理器 + 存儲器(內含程序指令)。

• 可執行權利要求 1-8 所述的方法。

3. 權利要求 10(計算機可讀存儲介質)

• 存儲可執行權利要求 1-8 所述方法的指令,使計算機運行該方法。

從屬權利項

2. 權利要求 2(數據清理與 Tokenize)

• 如果數據是自行獲取的,則在步驟 1) 之前需要先進行 數據清理 和 Tokenize。

3. 權利要求 3(數據清理細節)

• 數據清理包含:

• 智能抽取

• 按行去重

• 哈希去重

• 規則過濾

4. 權利要求 4(Tokenize 過程)

• Tokenize 步驟:

• 長文本分解為最小單位 Token。

• Token 轉換為向量數據結構。

5. 權利要求 5(數據序列結構)

• 數據序列是一維數組,包含 N 個連續 Token。

6. 權利要求 6(索引結構)

• 索引為一維數組:

• index_i 表示第 i 個數據序列的 第一個 token 在數據存儲中的偏移量。

7. 權利要求 7(索引操作)

• 數據操作(如抽取、打亂、切分)均基於 索引 進行,而不會實際修改存儲單元中的數據。

8. 權利要求 8(異步 IO)

• 批量讀取是透過異步 IO 實現,提高讀取效率。

關鍵技術特點與可能的專利價值

• 基於索引的數據處理:

• 透過索引進行數據處理(抽取、打亂、切分),提高存取效率,減少數據移動的開銷。

• 分塊與批量讀取:

• 利用數據塊來提高 I/O 效率,並使用異步 IO 進一步加速讀取。

• 數據清理與 Tokenize 方式:

• 具體描述了如何去重、過濾與 Tokenize,適用於 NLP 領域的 AI 訓練。

• 與設備和存儲介質的結合:

• 不僅保護方法,還擴展到硬體裝置(終端)與存儲介質,增強專利保護範圍。

可能的規避方式

1. 使用不同的索引方式:

• 例如使用二維索引表來記錄數據,而非單一索引數組。

2. 不同的數據切分方法:

• 例如按句子級別(而非固定長度的 Token 序列)切分數據。

3. 同步 IO 而非異步 IO**:

• 取消異步 IO,但仍保留批量讀取。

結論

此專利主要保護一種基於索引的 AI 訓練數據集處理方法,並擴展到裝置與存儲介質。其關鍵在於:

• 索引驅動的數據處理

• 數據打亂與切分

• 異步 IO 加速讀取

• Tokenize 與數據清理

可能的專利壁壘來自於 索引方式與數據切分技術,但仍有改進索引結構、變更數據抽取方式的空間來規避專利。

第二部分 新穎性、進步性的Prior Art Search前案資料檢索

提問

從公開資訊經過你強大的檢索引擎查詢以下專利權利項有沒有相同或技術近似的專利前案、技術前案、習知技術。

Felo search

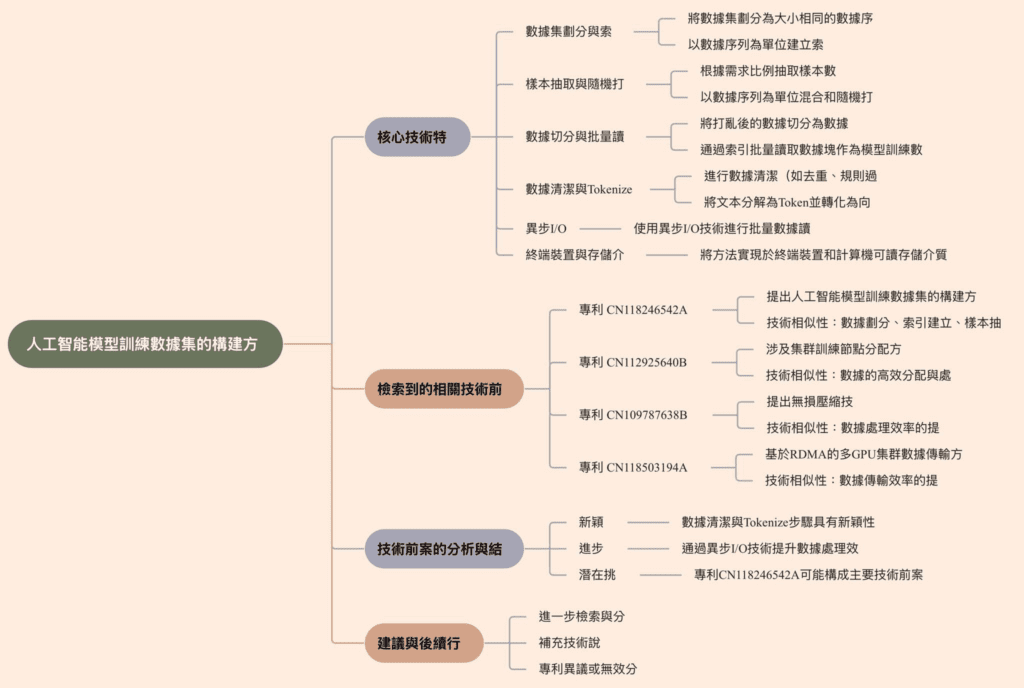

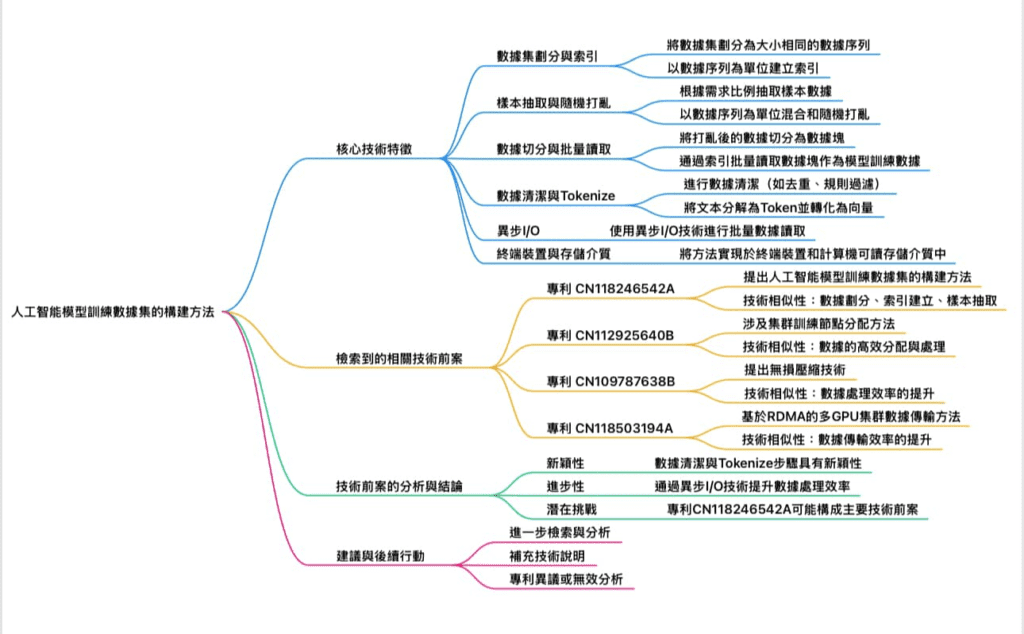

根據提供的專利權利要求,以下是針對該專利技術進行檢索與分析的結果,目的是確認是否存在相同或技術近似的專利前案、技術前案或習知技術。

檢索與分析結果

1. 核心技術特徵

該專利的核心技術特徵包括:

數據集劃分與索引:將數據集劃分為大小相同的數據序列,並以數據序列為單位建立索引。

樣本抽取與隨機打亂:根據需求比例抽取樣本數據,並以數據序列為單位混合和隨機打亂。

數據切分與批量讀取:將打亂後的數據切分為數據塊,並通過索引批量讀取數據塊作為模型訓練數據。

數據清潔與Tokenize:在自行獲取數據時,進行數據清潔(如去重、規則過濾)和Tokenize(將文本分解為Token並轉化為向量)。

異步I/O:使用異步I/O技術進行批量數據讀取,提升效率。

終端裝置與存儲介質:將方法實現於終端裝置和計算機可讀存儲介質中。

2. 檢索到的相關技術前案

根據檢索結果,以下專利或技術文獻與該專利的技術特徵具有一定的相似性:

(1) 專利 CN118246542A

技術內容:該專利提出了一種人工智能模型訓練數據集的構建方法,核心在於通過數據序列索引技術,實現數據的劃分、混合、打亂和切分操作,並通過索引批量讀取數據塊作為模型訓練數據。

技術相似性:

與本專利的數據劃分、索引建立、樣本抽取、隨機打亂和批量讀取技術高度相似。

同樣強調通過索引進行操作以減少存儲和通信資源的消耗。

差異點:該專利未明確提及數據清潔和Tokenize的步驟。

(2) 專利 CN112925640B

技術內容:該專利涉及一種集群訓練節點分配方法,旨在提升大規模分布式訓練的效率,並降低資源消耗。

技術相似性:

涉及數據的高效分配與處理,特別是在分布式環境中的數據傳輸與讀取。

使用異步I/O技術提升數據讀取效率。

差異點:該專利主要針對分布式訓練的資源分配,未聚焦於數據集的構建方法。

(3) 專利 CN109787638B

技術內容:該專利提出了一種無損壓縮技術,用於減少數據存儲成本,並支持高效的數據讀取。

技術相似性:

涉及數據處理效率的提升,特別是在大規模數據集的存儲與讀取方面。

差異點:該專利的重點在於數據壓縮,而非數據集的劃分與索引。

(4) 專利 CN118503194A

技術內容:該專利提出了一種基於RDMA(遠程直接內存訪問)的多GPU集群數據傳輸方法,旨在提升大規模模型訓練的數據傳輸效率。

技術相似性:

涉及數據傳輸效率的提升,與異步I/O技術的應用有一定關聯。

差異點:該專利主要針對分布式集群的數據傳輸,未涉及數據集的構建細節。

3. 技術前案的分析與結論

根據檢索結果,以下是對該專利技術的分析與結論:

(1) 新穎性

該專利的數據清潔與Tokenize步驟(如智能抽取、哈希去重、Token向量化)在檢索到的前案中未被明確提及,具有一定的新穎性。

但數據劃分、索引建立、樣本抽取、隨機打亂和批量讀取的技術特徵與專利CN118246542A高度相似,可能影響其新穎性判斷。

(2) 進步性

該專利通過異步I/O技術和索引操作提升數據處理效率,並結合數據清潔與Tokenize步驟,具有一定的技術進步性。

然而,若核心技術特徵(如數據劃分與索引)被認定為習知技術,則進步性可能受到挑戰。

(3) 潛在挑戰

專利CN118246542A可能構成該專利的主要技術前案,特別是在數據劃分、索引建立和批量讀取方面。

若該專利的數據清潔與Tokenize步驟被認定為常規技術,則整體專利的可專利性可能受到影響。

建議與後續行動

進一步檢索與分析:建議對專利CN118246542A進行更詳細的技術特徵比對,確認是否存在實質性差異。

補充技術說明:若該專利的數據清潔與Tokenize步驟具有創新性,應在專利說明書中強調其技術效果與優勢。

專利異議或無效分析:若該專利已授權,相關方可基於專利CN118246542A提出異議或無效宣告請求。

以上分析基於檢索結果與專利技術特徵,若需更深入的法律或技術支持,建議聯繫專業的專利代理人或律師進一步處理。

GPT4o 回覆

在評估您所述的專利權利要求時,需要考慮其與現有技術的相似性以及是否具備進步性。

根據現有的公開資訊,人工智慧模型訓練數據集的構建方法已被廣泛研究和應用。例如,專利 CN108764372B 提出了一種根據學習任務獲取具有預設數量且攜帶標註資訊的第一數據集的方法。(patents.google.com)

此外,專利 CN113191502A 公開了一種人工智慧模型在線訓練的方法及系統,涉及模型的編排及推理運行。(patents.google.com)

然而,您所述的專利透過將數據集劃分為等大小的數據序列,並以數據序列為單位建立索引,進行樣本抽取、混合、隨機打亂和均勻切分,最終透過索引批量讀取相應數據塊作為模型訓練數據。這種方法強調了基於索引的操作,避免對實際存儲數據的修改,從而提高數據處理效率。

目前,尚未發現與此完全相同的公開技術方案。因此,初步認為該專利的權利要求在現有技術中未見相同或類似的公開,並且具備一定的進步性。