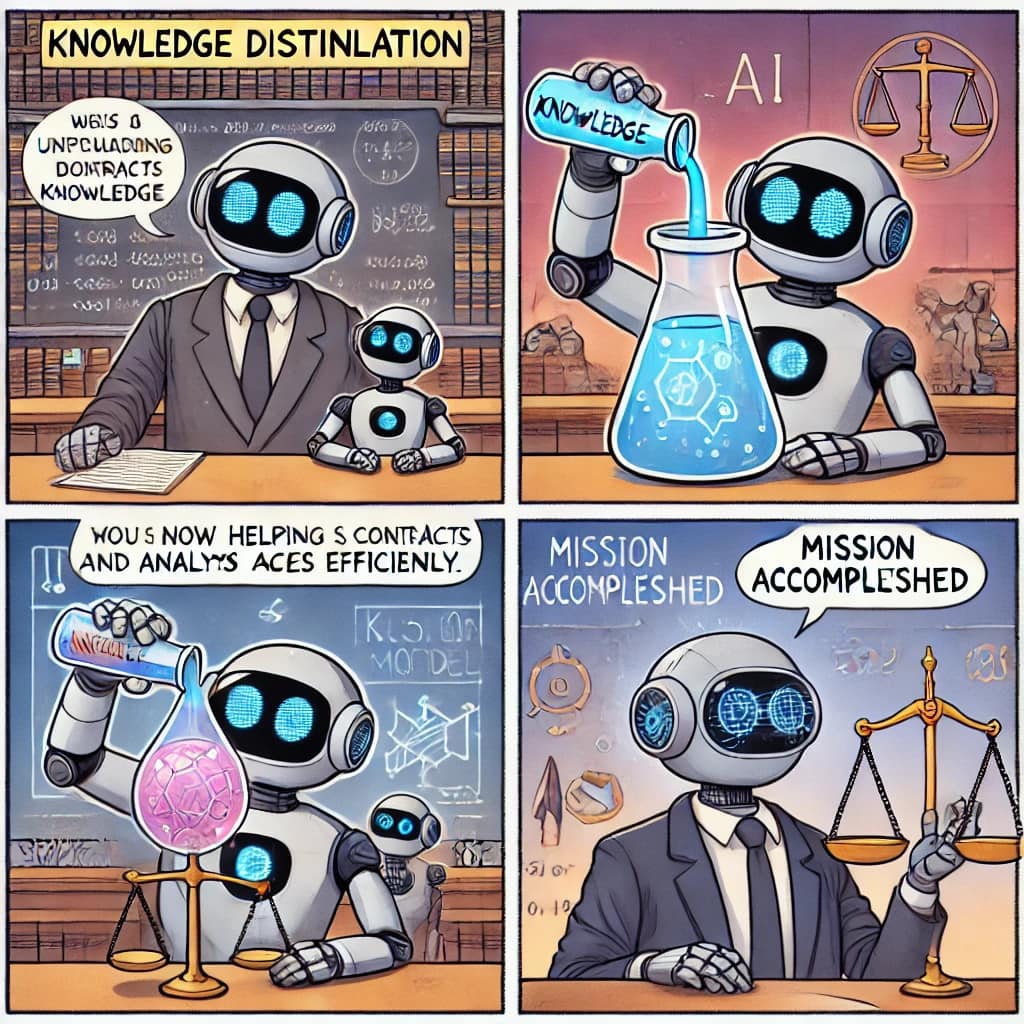

跋子|#普法知識蒸餾

最近台灣的法律人隨著 GenAI, AGI競賽的白熱化,逐漸有在以專業精神,追粉大自然語言模型的發展。這是一樁好事,值得來白話法普一下。

先來一段「廢話知識蒸餾」

「知識蒸餾」的過程、結果以及適用的基礎原理,比較像是知識的「萃取」而非知識的「蒸餾」囉,除非使用蒸餾一詞,「是指從一坨骯髒的水蒸餾出潔淨可以直接喝的水的目的而使用的技術」,與其稱之為「萃取」不如要強調吃了數據的怪獸,生成各種數據的大模型,再將一身的髒東西數據去除掉之後的數據,還是源自於原始數據的來源者,不是源自於大模型本身的本質,所以要稱之為「知識蒸餾~原始數據擁有者的知識要從吃數據怪獸的大模型的肚子裡蒸餾出來」

廢話說完了,再來一段「知識蒸餾的廢話」

蒸餾是指選定一個綜合能力強、參數規模大的1)閉源,但以API讓開發者使用的,或2)開源將模型全揭露供開發者下載大模型成為本地使用的。

**開源大模型,可以這麼去了解

就是任何人都可以下載安裝開源大模型到自己的機器裡面,讓他變成自己家裡的基礎大模型「俗稱本地大模型」,可以供自己研究、繼續訓練、微調成自己的大模型,叫做本地大模型或者什麼厲害的「主權AI」之用;當然也可以拿來作為教師模型經過蒸餾技術訓練自己開發或者拿另一個開源的、較小參數規模的大模型(SLM)。

「教師模型—學生模型」的訓練是使用一個叫做「知識蒸餾」的技術。

開發者將提示詞1手動給教師大模型,教師大模型吐出生成的答案1;開發者將生成答案1作為提示詞2手動或(寫個演算法)自動給教師大模型,教師大模型吐出生成的答案2;開發者將生成答案2作為提示詞3手動或自動給教師大模型生成答案3; 一再重複同樣的動作「如喂給教師模型的提示詞是X,且教師模型生成答案是Y,生成答案第Y次的內容=第X+1此提示詞的內容」的過程和及預計達成的成果,就叫做「 知識蒸餾」。

簡單的說,在此公式中,提示詞Y等於從前一次教師模型生成的答案直接「複製—貼上」學生模型的動作是一種「複製—貼上」的行為,但是其標的是GenAI生成的文字組合,並不是一種著作,(#目前的各國的共識是如為著作,著作權歸屬於發揮創意提供提示詞的開發者,而非大模型的擁有者)所以 #只是物理上的複製—貼上,#而非著作權法禁止的侵權行為。

以文本生成GenAI為例,可以被作為教師模型的,通常是參數重量級的吃數據怪獸,例如閉源的GPT4o, Gemini 2.0 , Claude 3; 開源的 Llama 3.1, Llama 3.2, Llama3.3系列, Qwen 2.5, Deepseek v3, Deepseek r1。

補充一下:常用的開源大模型,還有由Google 團隊開發並開源,通常不作為教師模型,而作為基礎模型、學生模型之用。因為Gemma被釋出的參數規模的版本,最高只有27B。

以上供大家參考。(本文與大模型多輪協作)